Wie in bereits beschrieben, crawlt eine Suchmaschine regelmäßig die ihr bekannten Webseiten. Der Energieverbrauch hängt dabei von der Anzahl zu crawlender Seiten, der benötigten Rechenleistung pro Crawlingdurchlauf sowie der Wiederholungsfrequenz pro Seite ab.

Auf die Anzahl der zu crawlender Seiten lässt sich hierbei von der Gesamtzahl der Google bekannten URLs schließen. Wie bereits hergeleitet, dürfte das Verzeichnis aller verfügbarer Seiten zwischen 40 und 80 Milliarden Einträge umfassen. Da Google zwischen indexierten und nicht indexierten Seiten differenziert, könnte sich die Frequenz von wiederholten Crawlingdurchläufen bei indexierten und nicht indexierten Seiten unterscheiden.

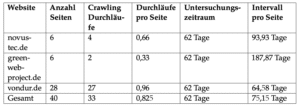

Um die Wiederholungsfrequenz der Crawlingdurchläufe zu erfassen, wurden die Daten von drei Google bekannten Websites in der Google Search Console untersucht. Dabei wurde über einen Zeitraum von 62 Tagen analysiert, zu welchen Zeitpunkten indexierte und nicht indexierte Seiten von Google gecrawlt wurden.

Während des Untersuchungszeitraums wurden insgesamt 142 Crawlingdurchläufe bei indexierten Seiten festgestellt. Bei einer Gesamtzahl von 100 indexierten Seiten und 142 Crawlingdurchläufe lassen sich 1,42 Durchläufe pro Seite für den Zeitraum von 62 Tagen berechnen. Somit ergibt sich ein Crawling-Intervall von 43,66 Tage für indexierte Seiten.

Für nicht indexierte Seiten wurden während des Untersuchungszeitraums 11 Crawlingdurchläufe festgestellt. Daraus ergeben sich unter der Berücksichtigung von einer Gesamtzahl von 49 nicht indexierten Seiten und 33 Crawlingdurchläufen, 0,825 Durchläufe pro Seite für den Zeitraum von 62 Tagen. Das entspricht einem Crawling-Intervall von 75,15 Tage für nicht-indexierte Seiten.

Wie im letzten Abschnitt beschrieben, wird von 30 bis 60 Milliarden indexierter Seiten und 10 bis 20 Milliarden nicht indexierter Seiten ausgegangen. Wenn die berechneten Crawling-Intervalle auf diese Schätzungen angewendet werden, kommt man zu dem Schluss, dass Google täglich durchschnittlich zwischen 399,2 Millionen und 798,4 Millionen indexierte sowie zwischen 133,0 Millionen und 266,1 Millionen nicht indexierte Seiten, also insgesamt zwischen 472,2 Millionen und 1,1 Milliarden Seiten, crawlen müsste.