Das zuvor beschriebene Grundtraining ist ein wichtiger Bestandteil der KI-basierten Suchmaschinen, um Texteingaben mit Sprache zu verstehen und darauf antworten zu können. Hierfür kann für die Suchmaschine ein eigenes Large Language Modell trainiert oder auf ein vorhandenes aufgebaut werden. Bing Chat beispielsweise nutzt GPT-4 von OpenAI als Grundlage.

Für die GPT-4 Version gibt es keine öffentlich zugänglichen Angaben. Das Konzept des KI-Modells sowie der Trainingsprozess dürfte sich jedoch nicht stark von GPT-3 unterscheiden. Als Weiterentwicklung von GPT-3 dürfte GPT-4 jedoch deutlich mehr Parameter besitzen als die Vorgängerversion. Die Angaben und Schätzungen der Parameterzahl variiert jedoch sehr stark. So wird etwa eine Parameteranzahl zwischen 1 Billion, 10 Billionen, 100 Billionen und darüber hinaus erwähnt.

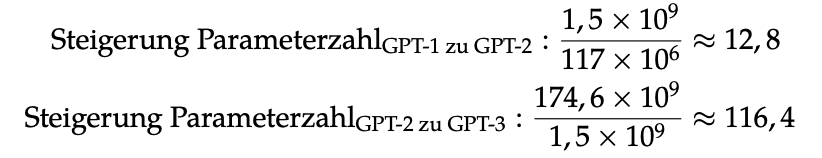

Untersucht man den Entwicklungsverlauf von GPT-1 mit 117 Millionen Parametern zu den 1,5 Milliarden Parametern, zeigt sich, dass GPT-2 12,8-mal mehr Parameter besitzt. Analysiert man den Entwicklungsverlauf von GPT-2 mit 1,5 Milliarden Parametern zu den 174,6 Milliarden Parametern von GPT-3, ergibt sich eine 116,4-fache Steigerung.

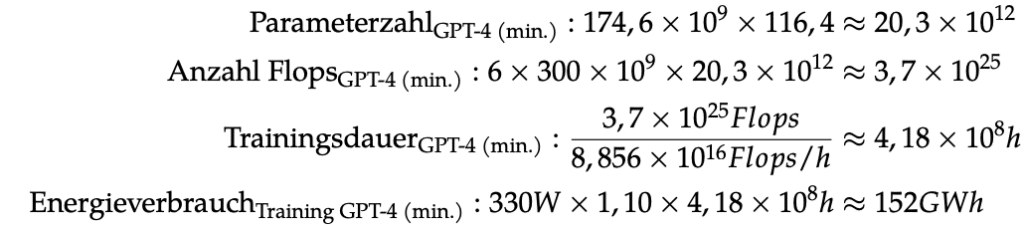

Wendet man den Faktor von 116,4 auf die Parameterzahl von GPT-3 an, ergibt sich eine geschätzte Parameterzahl von ca. 20,3 Billionen. Bei gleicher Tokenanzahl und weiterhin 6 Flops pro Parameter pro Token ergibt sich für das Training ein Rechenaufwand von 37 Quadrillionen Flops. Somit ergeben sich bei der gleichen verwendeten Hardware eine Trainingsdauer von 418 Millionen Stunden und ein Energieverbrauch von 152 GWh für das Training.

Dabei ist jedoch anzumerken, dass GPT-1 2018, GPT-2 2019, GPT-3 2020 und GPT-4 2023 veröffentlicht wurden. Infolge des deutlich längeren Entwicklungszeitraums besteht möglicherweise eine deutlich höhere Steigerung der Parameterzahl für GPT-4. Zudem fällt auf, dass die Steigerung der Parameterzahl verglichen mit den verschiedenen Versionen stark zunimmt.

Unter Einbezug des dreimal so langen Entwicklungszeitraums von GPT-4 kann auch eine deutlich höhere Parameterzahl angenommen werden. Bei einem dreifachen Entwicklungszeitraum ist es möglich, ebenfalls die Steigerung der Parameterzahl dreifach durchzuführen. Somit würde sich eine geschätzte Parameterzahl von 275,36 Billiarden Parameter ergeben. Diese Zahl übertrifft jedoch stark die Schätzungen von 1 Billion bis 100 Billionen. Die höheren Schätzungen gehen nicht von einer dreifachen Steigerung aus, sondern nähern sich einer 1,35-fachen Steigerung an und würden 107,41 Billionen Parameter ergeben.

Mit der größeren Schätzung der Parameterzahl von ca. 107,41 Billionen, bei gleicher Tokenanzahl und weiterhin 6 Flops pro Parameter pro Token ergibt sich für das Training ein Rechenaufwand von 496 Quadrillionen Flops. Somit ergeben sich bei der gleichen verwendeten Hardware eine Trainingsdauer von 5,6 Milliarden Stunden und ein Energieverbrauch von 2,03 TWh für das Training.