Für das Aktualisierungstraining sind deutlich mehr gecrawlte Seiten notwendig, da diese als Grundlage für ein umfangreiches Wissen des KI-Modells dienen müssen. Je besser die Antworten einer KI-basierten Suchmaschine sein sollen, desto mehr Inhalte müssen eingespeist werden.

Wie bereits hergeleitet, dürfte Google zwischen 40 und 80 Milliarden Webseiten aus der URL-Discovery kennen, wovon jedoch nur 30 bis 60 Milliarden Seiten indexiert sind. Google crawlt hierbei die gefundenen Webseiten, analysiert diese und entscheidet dann, ob sie indexiert werden oder nicht.

Um mit Index-basierten Suchmaschinen beim Informationsumfang mithalten zu können, ist es erforderlich, ebenso viele Webseiten zu berücksichtigen. Dementsprechend müssen ebenfalls zwischen 40 und 80 Milliarden Webseiten gecrawlt und anschließend gefiltert werden.

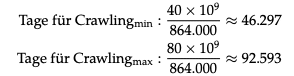

Wie beschrieben, könnte ein Server ca. 864.000 Webseiten pro Tag crawlen. Um 40 Milliarden Seiten für das Aktualisierungstraining zu crawlen, würde ein einzelner Server 46.297 Tage benötigen und bei 80 Milliarden Seiten 92.593 Tage. In der Realität werden jedoch mehrere Crawler gleichzeitig verwendet. Da dies jedoch keinen Einfluss auf den Gesamtenergieverbrauch hat, kann die Dauer des Crawlings für weitere Berechnungen genutzt werden.

Berechnet man den Energieverbrauch mithilfe der Rechendauer mit einem durchschnittlichen Energieverbrauch von 2880 Wh pro Tag und unter Berücksichtigung der PUE mit dem Faktor 1,10, kommt man auf einen minimalen serverseitigen Energieverbrauch von ca. 147 MWh und einen maximalen Verbrauch von 293 MWh pro Aktualisierungstraining.

Auch beim Crawling für das Aktualisierungstraining führt der Datentransfer zu einem externen Energieverbrauch. Selbst wenn für das Aktualisierungstraining nur die Textinhalte der Webseite benötigt und ausschließlich das HTML-Dokument beim Crawling geladen wird, ist von einem Energieverbrauch von ca. 0,01 Wh pro Seite auszugehen.

Unter Einbezug von 40 bis 80 Milliarden zu crawlenden Webseiten ergibt sich somit ein Gesamtenergieverbrauch von 400 MWh bis 800 MWh durch den Datentransfer.

Die berechneten Werte beziehen sich dabei auf eine vollständig durchgeführte URL-Discovery für das Aktualisierungstraining. Wird nun ein sinnvolles Intervall von beispielsweise einmal pro Quartal gewählt, zeigt sich, dass sich der Energieverbrauch dementsprechend multipliziert.

Bei vier durchgeführten Crawling-Prozessen ergeben sich ein serverseitiger Energieverbrauch von 588 MWh bis 1172 MWh und ein externer Verbrauch von 1,6 GWh bis 3,2 GWh.