Die Generierung einer natürlichen, textbasierten Antwort gehört zu den Hauptmerkmalen einer KI-basierten Suchmaschine. Während dieses Prozesses wird die Antwort speziell für die Anfrage des Nutzers generiert. Der Energieverbrauch der Generierung hängt dabei maßgeblich von der dafür benötigten Rechenleistung, des Antwortumfangs sowie der Anzahl der Nutzeranfragen ab.

Google Bard, welches auf dem KI-Modell LaMDA beruht, besitzt nur 137 Milliarden Parameter.

Daher würde Google Bard bei 20 Wörtern pro Sekunde im Durchschnitt 6,3 GPUs benötigen. Im Experiment wurde gezeigt, dass Google Bard mit durchschnittlich 1463,55 Zeichen deutlich ausführlichere Antworten generiert. Um dieses KI-Modell mit Bing Chat vergleichen zu können, wird im Weiteren ebenfalls von 31 Wörtern pro Antwort ausgegangen.

Bei 20 Wörtern pro Sekunde und 31 zu generierenden Wörtern ergibt sich eine durchschnittliche Rechenzeit von 1,55 Sekunden pro Antwort.

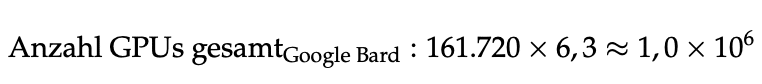

Wird nun von ebenfalls 3,29 Billionen Suchanfragen ausgegangen, ergibt sich bei einer durchschnittlichen Rechendauer von 1,55 Sekunden eine Gesamtrechenzeit von 5,1 Billionen Sekunden (161.720 Jahre).

Um diese Rechenzeit innerhalb eines Jahres erbringen zu können, wird 161720-mal die zuvor berechnete Anzahl an GPUs benötigt, die durchgehend und zeitgleich die Anfragen bearbeiten. Daraus ergibt sich eine benötigte Gesamtanzahl von 1 Million GPUs.

Bei einem Energieverbrauch von 330W pro GPU und einem PUE von 1,10 sowie einer Rechendauer von einem Jahr ergibt sich für 1 Million GPUs ein jährlicher Energieverbrauch von 3,2 TWh für die Antwortgenerierung von Google Bard.

Der große Unterschied im Energieverbrauch der Antwortgenerierung von Google Bard und Bing Chat ist nur auf die unterschiedlichen KI-Modelle zurückzuführen. Dies zeigt die Wichtigkeit der Auswahl eines passenden KI-Modells als Grundlage der KI-basierten Suchmaschine.