Der Energieverbrauch durch das Finetuning und Bias bei KI-basierten Suchmaschinen hängt davon ab, wie rechenintensiv diese Prozesse sind und wie groß die Datenmenge ist.

OpenAI bietet für das KI-Modell Davinci, das vergleichbar mit dem GPT-3.5 KI-Modells ist, eine Schnittstelle für Entwickler, um ein Finetuning für ein KI-Modell mit eigenen Daten vorzunehmen. Dies ermöglicht Einblicke in die benötigte Rechenleistung, die beim Finetuning der KI-Modelle notwendig ist. Dafür wurde ein Experiment durchgeführt, bei dem die Traingingsdaten über das Command Line Tool (CLI) von OpenAI an die Schnittstelle gesendet, das Finetuning für das KI-Modell Davinci gestartet und die Trainingsdauer mit der Größe der Trainingsdaten verglichen wurden. Dabei wurden die Statusmeldungen des Finetuningsprozesses beobachtet.

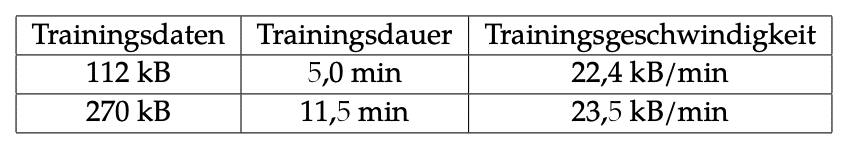

Bei diesem Experiment wurden zwei Finetuningprozesse gestartet. Bei dem ersten Trainingsversuch wurden 112 kB an Daten eingespeist, wobei der Trainingsprozess 5,0 Minuten gedauert hat. Beim zweiten Durchlauf wurden 270 kB an Trainingsdaten innerhalb von 11,5 Minuten verarbeitet. Daraus ergibt sich eine Trainingsgeschwindigkeit von 22,4 kB/min beim ersten Finetuningprozess und 23,5 kB/min beim zweiten Durchlauf.

Da sich das Preismodell des Finetunings des Davinici-KI-Modells nicht von den Kosten der Anbindung von GPT-4 unterscheidet, ist es naheliegend, dass eine ähnliche Rechenleistung für die Schnittstelle bereitgestellt wird. Bei dieser Annahme ist es wahrscheinlich, dass 8 GPUs für den Betrieb bereitgestellt werden.

Berechnet man den Energieverbrauch beim Finetuning mithilfe der gesammelten Daten, ergibt sich ein Verbrauch zwischen 2,06 Wh/kB und 2,16 Wh/kB.

Auch wenn sich diese Daten nur auf das Finetuning durch externe Entwickler beziehen, dürften die Rechenprozesse identisch sein. Beim Finetuning des gesamten KI-Modells wird vermutlich deutlich mehr Rechenleistung genutzt. Dadurch dürfte sich die höhere Rechenleistung die Trainingsgeschwindigkeit proportional erhöhen. Jedoch ist es wahrscheinlich, dass sich der Energieverbrauch pro kB an Eingabedaten in derselben Größenordnung bewegt.

Da keine Angaben bezüglich des Umfangs des Finetunings von GPT-3, GPT-4 oder Google Bard öffentlich zugänglich sind, ist es nicht möglich, den konkreten Energieverbrauch dieser KI-Modelle zu berechnen.